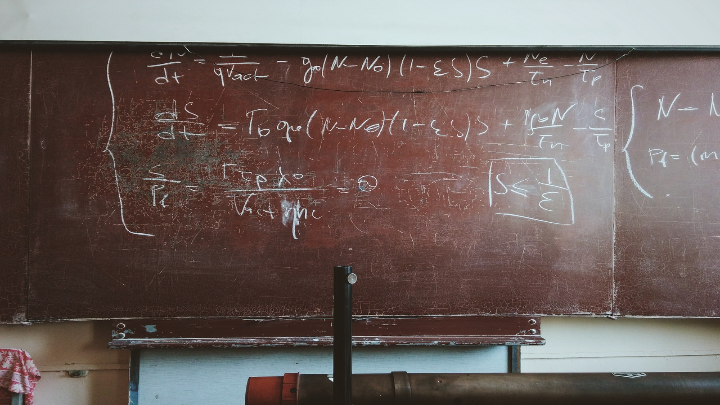

A través de las plataformas digitales las empresas han simplificado, acelerado y automatizado los procesos de selección, evaluación, promoción y desvinculación de trabajadores. La inteligencia artificial (IA) es la razón de la llamada cuarta revolución industrial. Los algoritmos son los “insumos” que alimentan todos estos procesos.

Son parámetros dinámicos que permiten encontrar las mejores opciones para cualquier toma de decisión. Son una suerte de flujograma con pautas predefinidas para encontrar conclusiones. Para algunos, es un sistema de aprendizaje constante a través de la propia experiencia y las adecuaciones que se implementen.

Los algoritmos están diseñados para mejorar (“aprender”) sobre la base de la experiencia y encontrar la opción menos falible al seleccionar al mejor postulante, elegir al trabajador que puede ascender o recibir un bono, o identificar al personal con menor desempeño.

Las plataformas digitales son rápidas, simples, pero ¿infalibles? Estos nuevos métodos, por más eficientes que resulten, pueden, de no estar bien gestionados, generar efectos negativos, incluso afectando los derechos fundamentales de los trabajadores.

Como es evidente, por la inmensa cantidad de datos disponibles, es muy difícil determinar a qué información está efectivamente accediendo la computadora o, en todo caso, cómo es que dicha información está siendo procesada por esta. Además, todos los datos a los que la computadora podrá acceder son finalmente proporcionados por seres humanos y, por tanto, no son ajenos a sesgos sociales. Es posible, entonces, que las predicciones realizadas por las computadoras no sean del todo objetivas, sino que estén fundadas en información no necesariamente certera, incluso discriminatoria, y, en consecuencia, las soluciones que planteen sean contrarias a la regulación laboral.

Por ejemplo, la computadora podría detectar que, usualmente, los postulantes que tienen hijos no marcan el casillero del formulario que indica “el trabajador está dispuesto a ser trasladado al extranjero”. En esa línea, podría concluir que, para puestos de trabajo en los que se requiera traslados al extranjero, ningún trabajador con hijos podría acceder. Podría también suceder que la computadora determine que hay una mayor rotación de trabajadores locales que de trabajadores venezolanos y, por tanto, otorgue preferencias de contratación a estos últimos respecto de los primeros, dado que permanecen más tiempo en la empresa.

También hay discriminación basada en la experiencia. Si la mayoría de los candidatos contratados son mujeres, la IA puede tender a preferir a mujeres. Puede existir discriminación también sobre personas que no tienen LinkedIn o simplemente no usan las redes sociales (en este caso puede discriminarse por edad o pertenencia a minorías religiosas). La menor información disponible en internet puede generar menos “algoritmos favorables” para un trabajador.

Existen empresas globales que han sido denunciadas por utilizar “algoritmos” que han terminado discriminando colectivos por razón de sexo, nacionalidad, edad, religión, etcétera. La repercusión mediática ha sido tal que han tenido que retirar las plataformas digitales, brindar explicaciones públicas y hasta compensar a los trabajadores perjudicados.

La IA también puede ser utilizada para escoger y monitorear el desempeño de los asesores legales externos de la empresa. Es posible, con ayuda de macrodatos, conocer los juicios favorables, los movimientos de asociados y socios, los clientes, las apariciones en redes sociales, los reconocimientos internacionales, etcétera, y, tras ello, “rankear” a las firmas legales.

Las normas internacionales y nacionales prohíben la discriminación, no solo en las ofertas de empleo sino también en cualquier proceso de gestión humana. En estos casos, dependiendo de cada país, hay sanciones administrativas e indemnizaciones por daños y perjuicios para los discriminados y hasta la nulidad de los actos de discriminación. Pero, más que la sanción administrativa, afecta a la reputación de la empresa.

Los algoritmos son necesarios, pero la actuación de la empresa no debe agotarse en ellos. No se pueden tomar decisiones solo basadas en ellos. Es necesario monitorear los resultados para que no se utilicen criterios de discriminación programados por los reclutadores o definidos por la propia IA sobre la base de la experiencia.

Tanto el proceso general de recopilación y selección de trabajadores como la determinación de los trabajadores perjudicados o beneficiados por los algoritmos deben ser revisados por los seres humanos. Debe tenerse claro que, ante supuestos posibles de diferenciación, generales o específicos, es necesario contar con una explicación razonable sobre los criterios empleados por la IA para reclutar a trabajadores.

Al final, en el equilibrio que debe existir entre los algoritmos y la valoración humana, se debe privilegiar esta última.

Add new comment